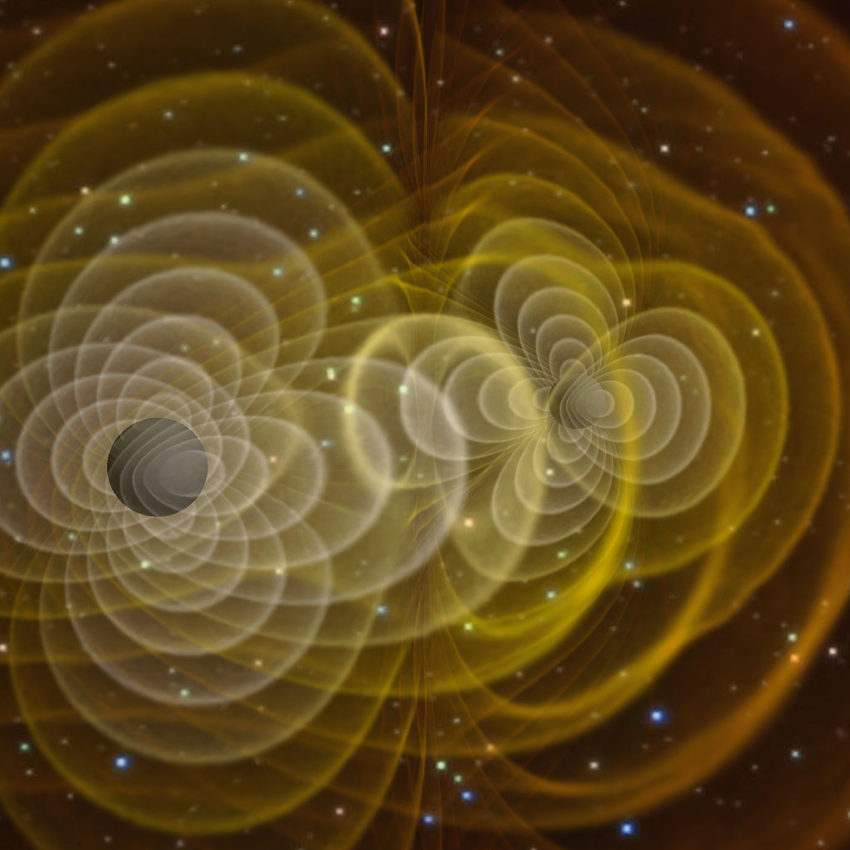

Kiedy fale grawitacyjne zostały po raz pierwszy wykryte w 2015 roku przez zaawansowane obserwatorium laserowe interferometru grawitacyjnego (LIGO), wywołały falę w społeczności naukowej, potwierdzając kolejną teorię Einsteina i wyznaczając narodziny astronomii fal grawitacyjnych. Pięć lat później wykryto liczne źródła fal grawitacyjnych, w tym pierwszą obserwację dwóch zderzających się gwiazd neutronowych w falach grawitacyjnych i elektromagnetycznych.

Ponieważ LIGO i jego międzynarodowi partnerzy kontynuują ulepszanie czułości swoich detektorów na fale grawitacyjne, będą mogli badać większą objętość wszechświata, dzięki czemu wykrywanie źródeł fal grawitacyjnych stanie się codziennością. Ten zalew odkryć zapoczątkuje erę astronomii precyzyjnej, która bierze pod uwagę zjawiska pozasłonecznych przekaźników, w tym promieniowania elektromagnetycznego, fal grawitacyjnych, neutrin i promieni kosmicznych. Realizacja tego celu będzie jednak wymagała ponownego i radykalnego przemyślenia istniejących metod wykorzystywanych do wyszukiwania i znajdowania fal grawitacyjnych.

Niedawno naukowiec obliczeniowy i kierownik ds. sztucznej inteligencji translacyjnej (AI), Eliu Huerta z amerykańskiego Departamentu Energii (DOE) Argonne National Laboratory, we współpracy ze współpracownikami z Argonne, University of Chicago, University of Illinois w Urbana-Champaign, NVIDIA i IBM opracowały nową platformę sztucznej inteligencji na skalę produkcyjną, która umożliwia przyspieszone, skalowalne i powtarzalne wykrywanie fal grawitacyjnych.

Ta nowa struktura wskazuje, że modele sztucznej inteligencji mogą być równie czułe, jak tradycyjne algorytmy dopasowywania szablonów, ale o wiele szybsze. Co więcej, te algorytmy sztucznej inteligencji wymagałyby jedynie niedrogiego procesora graficznego (GPU), takiego jak te stosowane w systemach gier wideo, aby przetwarzać zaawansowane dane LIGO szybciej niż w czasie rzeczywistym.

Zespół sztucznej inteligencji wykorzystany w tym badaniu przetworzył cały miesiąc — sierpień 2017 — zaawansowanych danych LIGO w mniej niż siedem minut, dystrybuując zestaw danych na 64 procesorach graficznych NVIDIA V100. Zespół sztucznej inteligencji wykorzystany przez zespół do tej analizy zidentyfikował wszystkie cztery podwójne połączenia czarnych dziur zidentyfikowane wcześniej w tym zestawie danych i nie zgłosił żadnych błędnych klasyfikacji.

„Jako informatyk, co jest dla mnie ekscytujące w tym projekcie” – powiedział Ian Foster, dyrektor działu Data Science and Learning (DSL) w firmie Argonne – „jest to, że pokazuje, w jaki sposób, przy użyciu odpowiednich narzędzi, metody sztucznej inteligencji można w naturalny sposób zintegrować z pracą naukowców – pozwalający im wykonywać swoją pracę szybciej i lepiej – zwiększając, a nie zastępując ludzką inteligencję”.

Wykorzystując zróżnicowane zasoby, ten interdyscyplinarny i wieloinstytucjonalny zespół współpracowników opublikował artykuł w Nature Astronomy prezentujący podejście oparte na danych, które łączy zbiorowe zasoby superkomputerowe zespołu, aby umożliwić odtwarzalne, przyspieszone wykrywanie fal grawitacyjnych oparte na sztucznej inteligencji.

„W tym badaniu wykorzystaliśmy połączone możliwości sztucznej inteligencji i superkomputerów, aby pomóc w rozwiązywaniu terminowych i odpowiednich eksperymentów na dużych zbiorach danych. Obecnie badania nad sztuczną inteligencją są w pełni odtwarzalne, a nie tylko upewniamy się, czy sztuczna inteligencja może zapewnić nowatorskie rozwiązanie wielkich wyzwań. – powiedział Huerta.

Opierając się na interdyscyplinarnym charakterze tego projektu, zespół oczekuje nowych zastosowań tej opartej na danych struktury wykraczającej poza wyzwania związane z dużymi danymi w fizyce.

„Ta praca podkreśla istotną wartość infrastruktury danych dla społeczności naukowej” – powiedział Ben Blaiszik, naukowiec z Argonne i University of Chicago. „Długoterminowe inwestycje dokonane przez DOE, Narodową Fundację Nauki (NSF), Narodowe Instytuty Standardów i Technologii i inne stworzyły zestaw cegiełek. Możliwe jest, że możemy połączyć te cegiełki razem w nowe i ekscytujące sposoby skalowania tej analizy i pomocy w dostarczaniu tych możliwości innym w przyszłości”.

Huerta i jego zespół badawczy opracowali nowe ramy dzięki wsparciu NSF, programu Argonne’s Laboratory Directed Research and Development (LDRD) oraz programu DOE Innowacyjny i nowatorski program obliczeniowy na teorię i eksperyment (INCITE).

„Te inwestycje NSF zawierają oryginalne, innowacyjne pomysły, które niosą ze sobą znaczącą obietnicę zmiany sposobu przetwarzania danych naukowych przybywających w szybkich strumieniach. Planowane działania wprowadzają przyspieszoną i heterogeniczną technologię obliczeniową do wielu naukowych społeczności praktykujących” – powiedział Manish Parashar, dyrektor Biuro Zaawansowanej Cyberinfrastruktury w NSF.